Highlight

Gemeinsam erfolgreich – unser valantic Team.

Lernen Sie die Menschen kennen, die mit Leidenschaft und Verantwortung bei valantic Großes bewegen.

Mehr über uns erfahrenVon der anfänglichen Inspiration, bis zur erfolgreichen Umsetzung

Unsere ganzheitliche Data Science Beratung bietet eine professionelle Begleitung bei der Entwicklung und Umsetzung Ihrer Strategie: Von der Identifizierung relevanter Anwendungsfälle bis zur produktiven Umsetzung von Machine Learning-Modellen und künstlicher Intelligenz.

Viele Unternehmen sehen den Einsatz von Data Science aktuell nur in einem wissenschaftlichen Kontext. Dabei sind Data Science Projekte für alle Unternehmen unverzichtbar, um klare Wettbewerbsvorteile in einem innovativen Markt zu sichern und Daten effektiv zu nutzen. Unternehmen können Geschäftsprozesse optimieren, die Qualität ihrer Produkte und Dienstleistungen steigern sowie Kosten reduzieren und die Kundenzufriedenheit erhöhen, indem sie Data Science zur Mustererkennung und für Prognosen (Forecasting) einsetzen. Die Vorteile liegen klar auf der Hand, doch vielen Unternehmen fehlt ein klarer Einstiegspunkt, um Data Science Projekte erfolgreich anzustoßen.

Da häufig ein klarer Leitfaden fehlt, um derartige Projekte greifbar zu machen, ist Data Science oft noch nicht in der betrieblichen Praxis angekommen. Unsere Data Science Beratung ist daher ganzheitlich auf die Entwicklung und Umsetzung Ihrer Data Science Strategie abgestimmt: von der Identifizierung relevanter Anwendungsfälle (Use Cases) über die Auswahl geeigneter Tools bis zur produktiven Umsetzung von Machine Learning (ML)-Modellen und dem Einsatz von künstlicher Intelligenz.

In 5 Schritten zum erfolgreichen Data Science Projekt

Dieses Whitepaper zeigt, wie man in wenigen Schritten Use Cases identifiziert und auf das eigene Unternehmen überträgt: Von den Einstiegshürden bis zu praxisnahen Beispielen.

Workshop: Data Science & Künstliche Intelligenz for Business

In diesem Workshop wird die Anwendungs- und Unternehmensperspektive eingenommen, um das Thema Data Science & Künstliche Intelligenz für Business Expert*innen greifbar zu machen.

Data Science Beratung für Unternehmen

Was ist Data Science? Data Science beschreibt die Extraktion von Wissen aus strukturierten, semistrukturierten und unstrukturierten Daten (Big Data) zur Optimierung von Produkten, Dienstleistungen und Prozessen innerhalb eines Unternehmens. Für die Gewinnung von Erkenntnissen aus Daten werden hierzu Modelle des maschinellen Lernens aufgebaut. Data Science ist der Schlüssel für Unternehmen, um prädiktive und präskriptive Analysen (Predictive & Prescriptive Analytics) durchzuführen.

Mit diesen Analysen werden unter anderem:

Gemeinsam mit den Kunden entwickelt valantic individuelle Use Cases, die von der Konzeption bis zur Implementierung ganzheitlich betreut werden. Mit Hilfe von Data Science Projekten ist es Unternehmen möglich, Kosten zu senken, die Qualität ihrer Produkte und Dienstleistungen zu steigern und folglich ihren Gewinn nachhaltig zu erhöhen.

Neben der Kompetenz im Bereich Data Science zeichnet sich valantic ganz besonders durch eine hohe Expertise und eine Vielzahl von erfolgreich durchgeführten Projekten im Bereich Business Intelligence (BI) und Data Warehousing (DWH) aus. Von dieser langjährigen Erfahrung in der Beratung profitieren bereits viele Unternehmen.

Effektive Datennutzung: Wo steht Ihr Unternehmen?

Gezielte Datentransformation setzt die Kenntnis des Nutzungsgrades der Daten voraus. Wir von valantic wissen, wie Sie Ihre Ausgangssituation ermitteln!

Ganzheitliche Beratung in der Entwicklung Ihrer Data Science Strategie

Die Beratung unserer Data Science Experten geht von der Identifizierung relevanter Use Cases, über die Auswahl geeigneter Tools bis hin zur produktiven Umsetzung von Machine Learning (ML)-Modellen und dem Einsatz von künstlicher Intelligenz (KI).

Data Science Projekterfahrung

valantic hat mit vielen erfolgreich durchgeführten Business Intelligence- und Data Warehouse-Projekten eine umfassende Expertise aufgebaut. valantic ist somit der ideale Partner für Data Science Projekte, da die Datenbereitstellung und -aufbereitung die Grundlage für erfolgreiche Data Science Analysen bildet.

Agiles Projektmanagement

valantic nutzt agile Vorgehensmodelle wie u.a. Scrum und Kanban. Unsere Data Science Projekte werden mittels kurzer Iterationszyklen und Feedbackschleifen umgesetzt, um Risiken und Fehler im Entwicklungsprozess zu minimieren. Das erhöht die Transparenz und Veränderungsgeschwindigkeit, was Data Science Projekte für unsere Kunden in der Folge kosteneffizienter macht.

Herstelleragnostisch

Unsere langjährigen Partnerschaften im Bereich Data Science ermöglichen es uns, auf umfangreiche Plattformen und Tools zuzugreifen, die wir in Unternehmen gewinnbringend einsetzen können. Für jedes Data Science Projekt gibt es eine passgenaue Lösung und Beratung. Profitieren Sie von unseren Partnerschaften mit IBM, SAP, Cognigy, Microsoft, AWS, UI Path und Tableau. Zusätzlich ermöglicht uns die Nutzung von Open-Source-Plattformen und -Tools, flexible und individuelle Data Science Lösungen für jeden unserer Kunden zu erstellen.

Use Cases – Welche verschiedenen Anwendungsmöglichkeiten gibt es?

Jedes erfolgreiche Data Science Projekt basiert im Kern auf einem geeigneten Use Case. Das Ziel eines jeden Data Science Use Cases ist es, Mehrwerte aus den verfügbaren Daten zu generieren. Daher sollte jeder Use Case individuell auf das Unternehmen abgestimmt sein. Durch Workshops und Schulungen hilft valantic Unternehmen dabei, Data Science Use Cases zu identifizieren, zu priorisieren und umzusetzen. Die folgenden Use Cases finden bereits Anwendung in vielen Unternehmen:

Prognosen mit Zeitreihenanalysen

(Time Series Forecasting)

Für die strategische Steuerung und Planung eines Unternehmens ist die zuverlässige Vorhersage zukünftiger Umsätze und weitere Kennzahlen sowie Key Performance Indicators (KPIs) entscheidend. Dazu werden Analysen von zeitlich geordneten Daten (Zeitreihen) durchgeführt. Neben klassischen statistischen Modellen wie dem ARIMA-Modell werden mittlerweile immer häufiger komplexe Deep Learning Modelle (Neuronale Netze) verwendet. Die Vorhersage von Kennzahlen hat eine enormes Potenzial für Unternehmen, da die Einsichten als stichhaltige Entscheidungsgrundlagen dienen.

Betrugserkennung

(Fraud Detection)

Viele Unternehmen leiden unter betrügerischen Aktivitäten, die teilweise enorme Kosten verursachen. Bei der Betrugserkennung werden Transaktionen untersucht, um ein Modell zu entwickeln, welches die Muster erkennt, die mit einer großen Wahrscheinlichkeit zu Betrug führen. Dieses Modell wird auf neue Daten und Echtzeitdaten angewendet, um zukünftige betrügerische Transaktionen zu erkennen und zu verhindern. Durch den Einsatz lassen sich vermeidbare Kosten einsparen.

Kundensegmentierung

(Customer Segmentation)

In der heutigen Zeit wird es für Unternehmen immer wichtiger die individuellen Bedürfnisse der Kunden zu verstehen und gezielt auf diese einzugehen. Mittels der Kundensegmentierung werden relevante Kundengruppen identifiziert und in sinnvolle Segmente eingeordnet. Mit dem Wissen über die Ähnlichkeiten und Unterschiede dieser Kundengruppen können Unternehmen gezielte Marketing- und CRM-Strategien entwickeln. Die Segmentierung bietet außerdem eine gute Grundlage für den Aufbau weiterer Data Science Analysen wie z. B. die Abwanderungs- oder Stimmungsanalyse.

Abwanderungsanalyse

(Churn Management)

Mit der Abwanderung von Kunden verlieren Unternehmen Einnahmequellen und Potenziale im Bereich Upselling, Cross-Selling und der Weiterempfehlung. Mit einer Abwanderungsanalyse kann die Abwanderungsrate (Customer Churn) eines Kunden bestimmt werden, die auf historischen Daten der Kunden basiert. Zusätzlich dient die Abwanderungsanalyse als Indikator, um Kunden mit entsprechend hohem Abwanderungsrisiko gezielt anzusprechen. Somit kann verhindert werden, dass Bestandskunden zur Konkurrenz wechseln und die Kundenzufriedenheit wird gesteigert.

Empfehlungssysteme

(Recommendation Systems)

Ein Empfehlungssystem soll Nutzer*innen aus einer großen Menge von Objekten (Dokumenten, Bildern, Videos oder Produkten), die für ihn relevantesten vorschlagen. Relevante Vorschläge werden durch die Erfassung des Nutzerverhaltens von einem Machine Learning-Algorithmus ausgegeben. Empfehlungssysteme können sowohl Kunden als auch Mitarbeiter*innen eines Unternehmens unterstützen. Durch die Empfehlung von geeigneten Produkten wird das Kundenerlebnis beispielsweise in einem Online-Shop nachhaltig verbessert. Zudem kann ein Empfehlungssystem Mitarbeiter*innen bei ihrer täglichen Arbeit unterstützen und so zu schlankeren Prozessen und geringeren Kosten führen, indem relevante Dokumente schneller gefunden werden.

E-Mail- und Textanalyse

(Natural Language Processing)

Unternehmen generieren täglich eine Unmenge von Textdokumenten. Dabei kann schnell die Übersichtlichkeit verloren gehen. Zudem bleiben fehlerhafte Einträge in unstrukturierten Textdaten oft unbemerkt. Durch den Einsatz von Text Analytics und NLP können Unternehmen Textdokumente effizient untersuchen, E-Mails und weitere Kundenkommunikation analysieren, Formulare automatisiert ausfüllen und relevante Information in großen Datenmengen auffinden. Durch die Technologie werden Kosten eingespart und Mitarbeiter*innen können sich auf die relevanten Aufgaben ihrer Arbeit fokussieren.

Stimmungsanalyse

(Sentiment Analysis)

Die Stimmungsanalyse ist eine Methode aus dem Bereich der natürlichen Sprachverarbeitung (NLP). Die Analyse wird verwendet, um festzustellen, ob Kunden eine positive oder eine negative Einstellung gegenüber den Produkten oder Dienstleistungen eines bestimmten Unternehmens haben. Unternehmen erreichen durch die Stimmungsanalyse ein besseres Verständnis über ihre Kunden und können gezielt und schnell auf Kundenwünsche oder Kritik reagieren. Die Ergebnisse der Stimmungsanalysen können in Dashboards dargestellt werden und den relevanten Abteilungen zur Verfügung gestellt werden. Durch den Einsatz der Stimmungsanalyse wird die Entscheidungsfindung durch kundenbasierte Einsichten unterstützt.

Supply Chain Management und Produktion

Die zunehmende Digitalisierung von Produktion und Supply Chain generiert schon heute enorme Datenmengen. Durch die intelligente Verknüpfung und Anreicherung der Daten mit Data Science Methoden ergeben sich zahlreiche Use Cases die einen echten Mehrwert in Punkto Transparenz, Optimierung und Automatisierung generieren. Mit Connected Plant implementieren wir gemeinsam mit unseren Kunden hochwertige Datenprodukte im Bereich Supply Chain Management und Produktion.

Informieren Sie sich hier über passende Use Cases im Bereich von Produktion und Supply Chain.

Finanzorganisation

Unternehmen verfügen durch die Digitalisierung der Prozesse über riesige Datenbestände Ihrer Kunden, Märkte und Produkte. Um diese Datenmengen für Unternehmen in aussagekräftige Erkenntnisse und Wettbewerbsvorteile zu transformieren und das Potential von Big Data voll auszuschöpfen, bedarf es einer durchdachten digitalen Strategie. Mit statistischen Methoden und Modellen aus dem Machine-Learning schaffen wir gemeinsam mit Ihnen die Grundlagen für fundierte Geschäftsentscheidungen und schnellere Prozesse im Finance-Controlling. Wir konnten hierzu bereits eine Vielzahl von Anwendungsfällen darstellen und mehrfach umsetzen.

Natürlich geht die Anwendung von Data Science noch weit über diese Use Cases hinaus. Weitere mögliche Use Cases sind u.a.: Predictive Maintenance & Qualitätssicherung in der Produktion.

valantic Training Center - Die Zukunft gemeinsam entwickeln

Herzlich Willkommen valantic Training Center!

Unsere Trainer begrüßen jedes Jahr rund 200 Teilnehmer in unserem Training Center in Hamburg oder bei den Kunden vor Ort. Neben einer Vielzahl an Schulungen, Workshops und Coachings der Hersteller IBM, Microsoft, Informatica, MicroStrategy, SAP und Anaplan, bietet unser valantic Training Center angefangen vom Wissensaufbau einer Technologie bis zur Zertifizierung individualisiertes sowie standardisiertes Training an. Ganz nach dem Motto „Migrieren Sie nicht nur Ihre Systeme, sondern auch Ihre Anwender*innen!“ stellt die valantic Training Center somit eine perfekte Ergänzung zum derzeitigen Projekt, eine Auffrischung zu neuen Highlights und Funktionen verschiedener Technologien oder eine Intensivierung bereits bestehender Kenntnisse dar.

Workshop: Data Science & Künstliche Intelligenz for Business

In der Schulung Data Science & Künstliche Intelligenz for Business identifizieren Sie Data Science Anwendungsfälle und lernen, diese auf Ihr Unternehmen zu übertragen.

Exzellenz im Know-how-Transfer – auch bei den Webinaren. Nachfolgend finden Sie eine Auswahl an ausgesuchten Webinaren rund um die Themen von Data Science.

Ein Schlüssel zum erfolgreichen Data Science Projekt ist die effektive Zusammenarbeit des gesamten Teams. Im Laufe der Zeit wurden daher verschiedene Vorgehensmodelle entwickelt, die als Leitfaden dienen und eine hilfreiche Struktur bieten. Unternehmen, die sich an Vorgehensmodellen orientieren, schaffen eine bessere Planbarkeit für Data Science Projekte und minimieren so Projekt-Risiken. Als erfahrener Partner unterstützt valantic seine Kunden bei der Projektplanung und nutzt hierfür die folgenden Modelle:

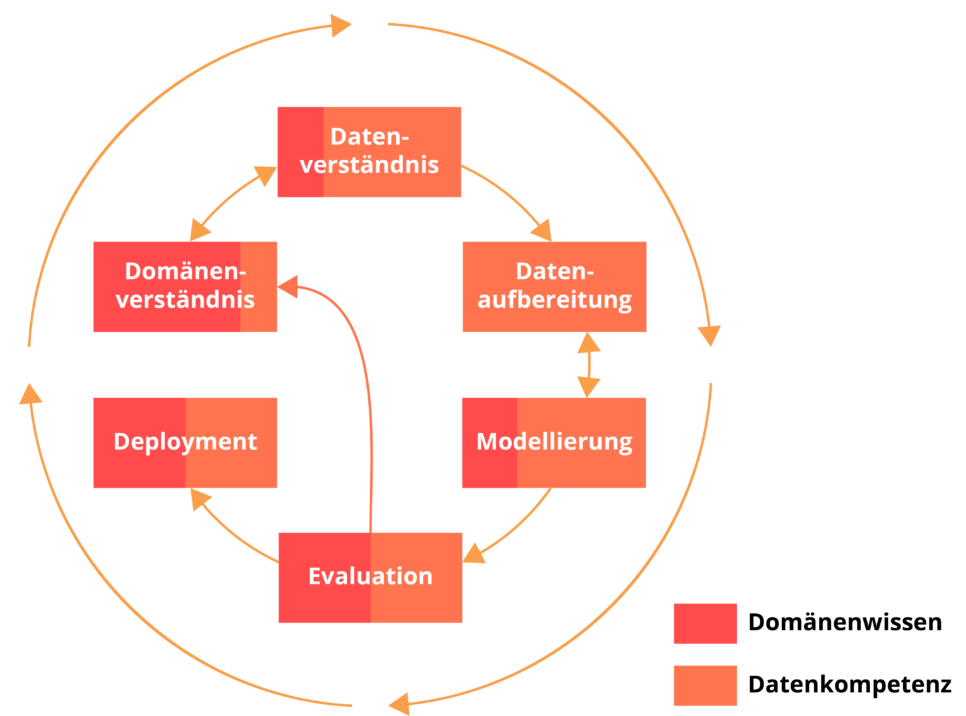

CRISP-DM

Das wohl bekannteste Modell für Data Science Projekte ist der Cross Industry Standard Process for Data Mining (CRISP DM). Dieses Modell teilt ein Projekt in sechs Phasen auf: Domänenverständnis, Datenverständnis, Datenaufbereitung, Modellierung, Evaluation und Deployment. Es wird also zunächst die inhaltliche Fragestellung betrachtet und dann die verfügbaren Daten gesammelt und gesichtet. Die Daten werden so aufbereitet, dass sich damit Machine-Learning-Modelle erstellen lassen. Im Anschluss werden diese Machine-Learning-Modelle bewertet und bereitgestellt. In der Praxis geschieht das entweder in Form von Berichten oder in der Form von Programmen, die kontinuierlich neue Daten verarbeiten und analysieren.

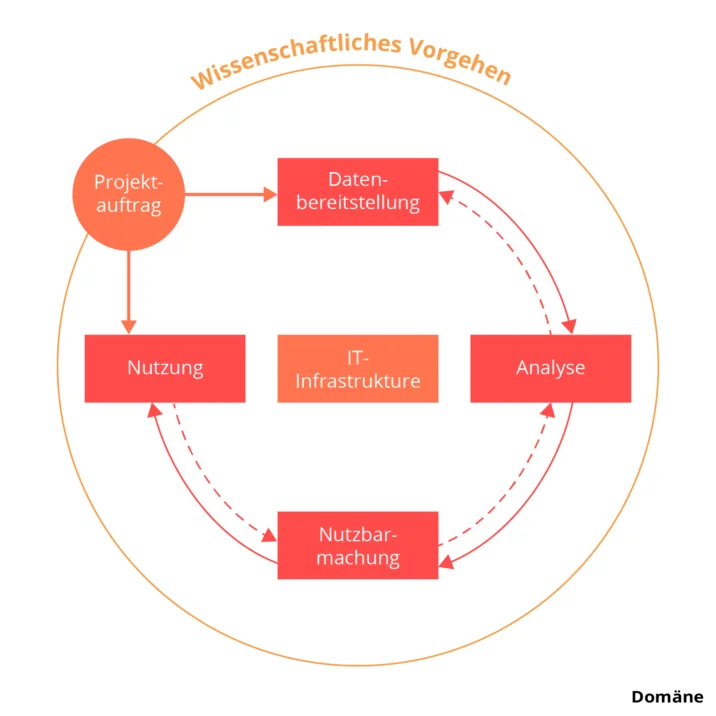

DASC-PM

Im Jahr 2019 hat eine Gruppe aus Mitgliedern verschiedener Universitäten und Unternehmen ein neues Modell erarbeitet, das Data Science Process Model (kurz DASC-PM). Es teilt ein Projekt in Schlüsselbereiche ein, welche die Grundlage für die Projektplanung bilden. Diese Bereiche umfassen den Projektauftrag, die Datenbereitstellung, die Analyse, die Nutzbarmachung und die abschließende Nutzung. Zudem werden der IT-Infrastruktur und dem wissenschaftlichen Vorgehen besondere Aufmerksamkeit geschenkt. Überlegungen zur Domäne, dem inhaltlichen Gebiet des Projektes, fließen in jeden Bereich mit ein. Für jeden Schlüsselbereich können Kompetenz- und Rollenprofile erstellt werden, die als Basis für die ideale Besetzung eines Data Science Teams dienen. Das DASC-PM wird kontinuierlich weiterentwickelt und um Erkenntnisse aus den verschiedensten Branchen und Themen erweitert.

Standardvorgehensmodell für Data Science Projekte

Welche Besonderheiten besitzt der Ablauf eines Data Science Projekts? Erfahren Sie es in unserem Standardvorgehensmodell!

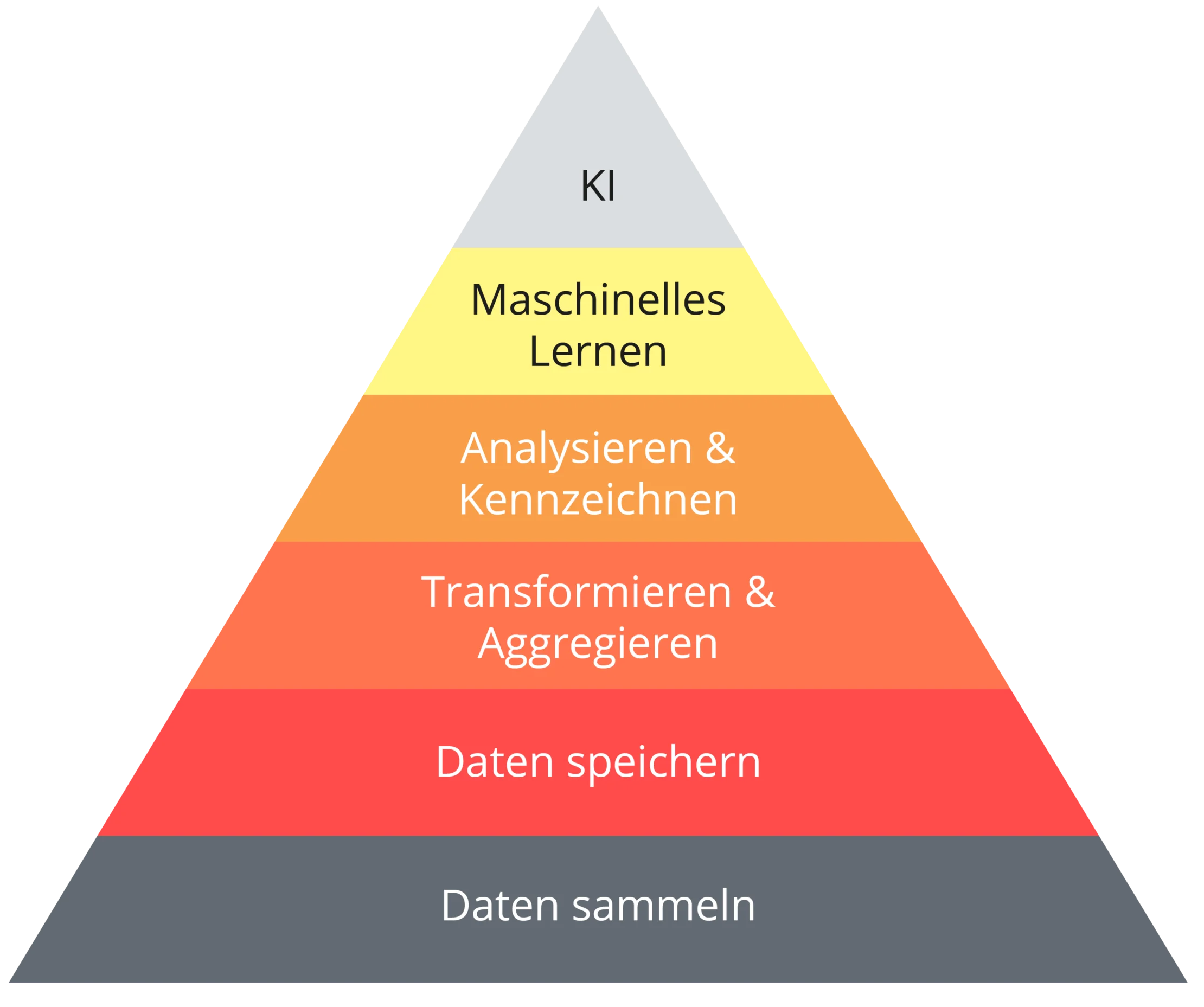

Data Engineering

Unternehmen unterschätzen oftmals die Relevanz von Data Engineering für Data Science Projekte. Die Datenbereitstellung und -aufbereitung spielt jedoch eine entscheidende Rolle für jeden Data Science Use Case, der produktiv in einem Unternehmen eingesetzt wird. Data Engineers befassen sich mit der Datensammlung, Datenbereinigung, Datenaufbereitung und der Validierung von Daten. Data Engineering garantiert dabei eine hohe Datenqualität und eine schnelle Datenverfügbarkeit. Beides sind Grundvoraussetzungen für validierte und sinnvolle Analysen und Lösungen.

Die Data Science Bedürfnishierarchie

Moderne Datenplattform

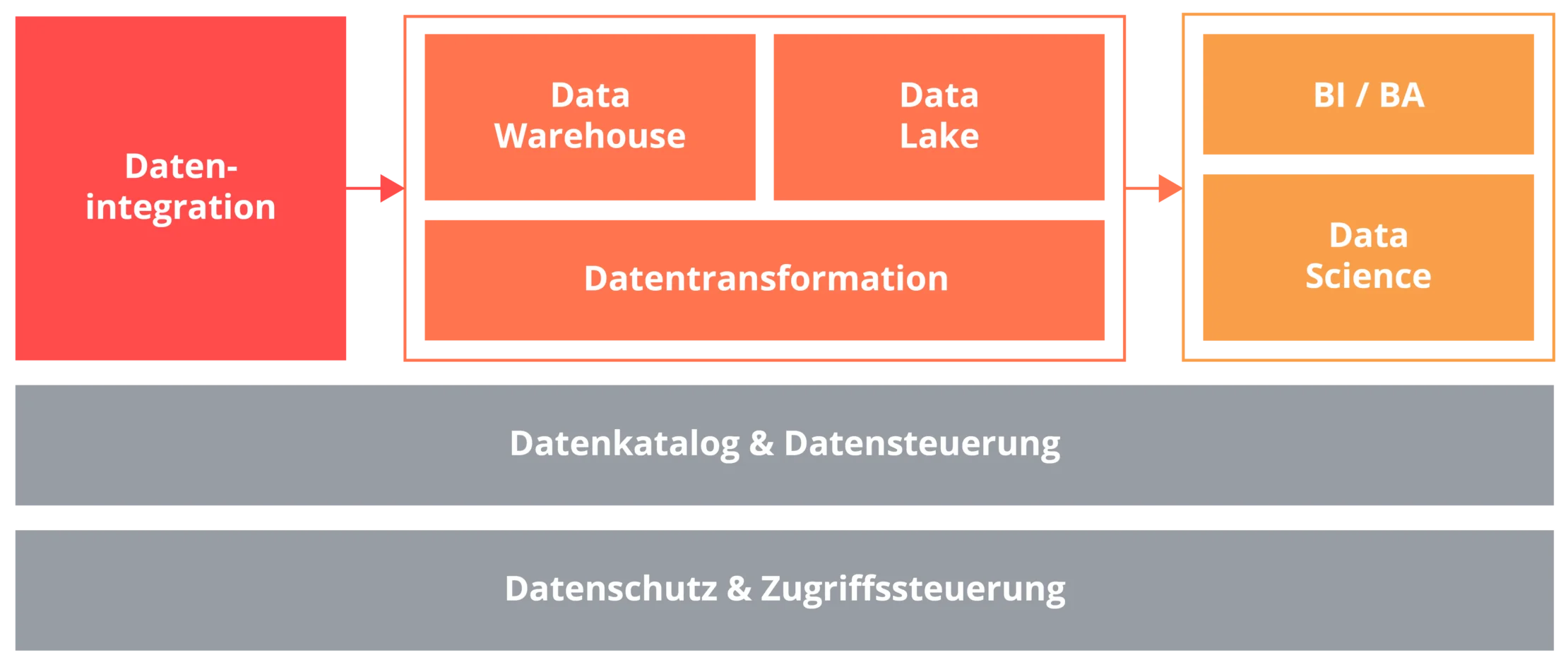

Eine moderne Datenplattform ist eine Sammlung von Tools und Technologien, die es Unternehmen ermöglicht, zu einer datengetriebenen Organisation zu werden. Oft sind Cloud-Lösungen für diesen Weg unverzichtbar, da sie eine hohe Skalierbarkeit und Elastizität der IT-Infrastruktur und somit eine schnelle Umsetzung von Anwendungsfällen sowie ein schnelles Wachstum von Unternehmen ermöglichen.

Die Eckpfeiler einer modernen Datenplattform sind das Data Warehouse und der Data Lake. Sie dienen als zentrale Bereitstellungsorte für strukturierte und unstrukturierte Daten (Big Data) und bereiten die Rohdaten mittels Datentransformation für Business Intelligence und Data Science Anwendungen auf. Die Datenintegration ist der Punkt, an dem der Aufbau einer Datenplattform beginnt. Hier werden Daten aus einer Vielzahl unterschiedlicher Datenquellen in das Data Warehouse oder den Data Lake geladen. Die Datentransformation ermöglicht die Bereinigung und Zusammenführung der Daten. Tools im Bereich Datenkatalog und Governance gestatten den Aufbau von Metadaten und Governance-Funktionen, um einen Katalog für Datenbestände zu erstellen, zu klassifizieren und zu verwalten.

Mit der zunehmenden Anzahl an Tools besteht die große Herausforderung darin, Datenschutzkontrollen und Zugriffsregelungen über dem gesamten Stack zu verwalten (Access Governance). Die heutigen Business Intelligence und Analytics Tools bieten den Nutzern Dashboards und Self-Service-Reports. Unternehmen, die sich über Business Intelligence hinaus mit prädiktiven Analysen und maschinellem Lernen beschäftigen, nutzen hierzu spezielle Data Science Tools.

Es gibt eine Vielzahl von Technologien, die sinnvoll in die Datenplattform des Unternehmens integriert werden müssen. Dafür sind eine hohe Expertise und Projekterfahrung im Bereich Data Engineering und Governance notwendig. Die Datenplattformen, die valantic zusammen mit seinen Kunden umsetzt, zeichnen sich durch eine passgenaue Toolauswahl, ein agiles Datenmanagement, sowie ein flexibles und schnelles Prozessmodell für die Datenbereitstellung und -aufbereitung aus.

Arten von Machine Learning

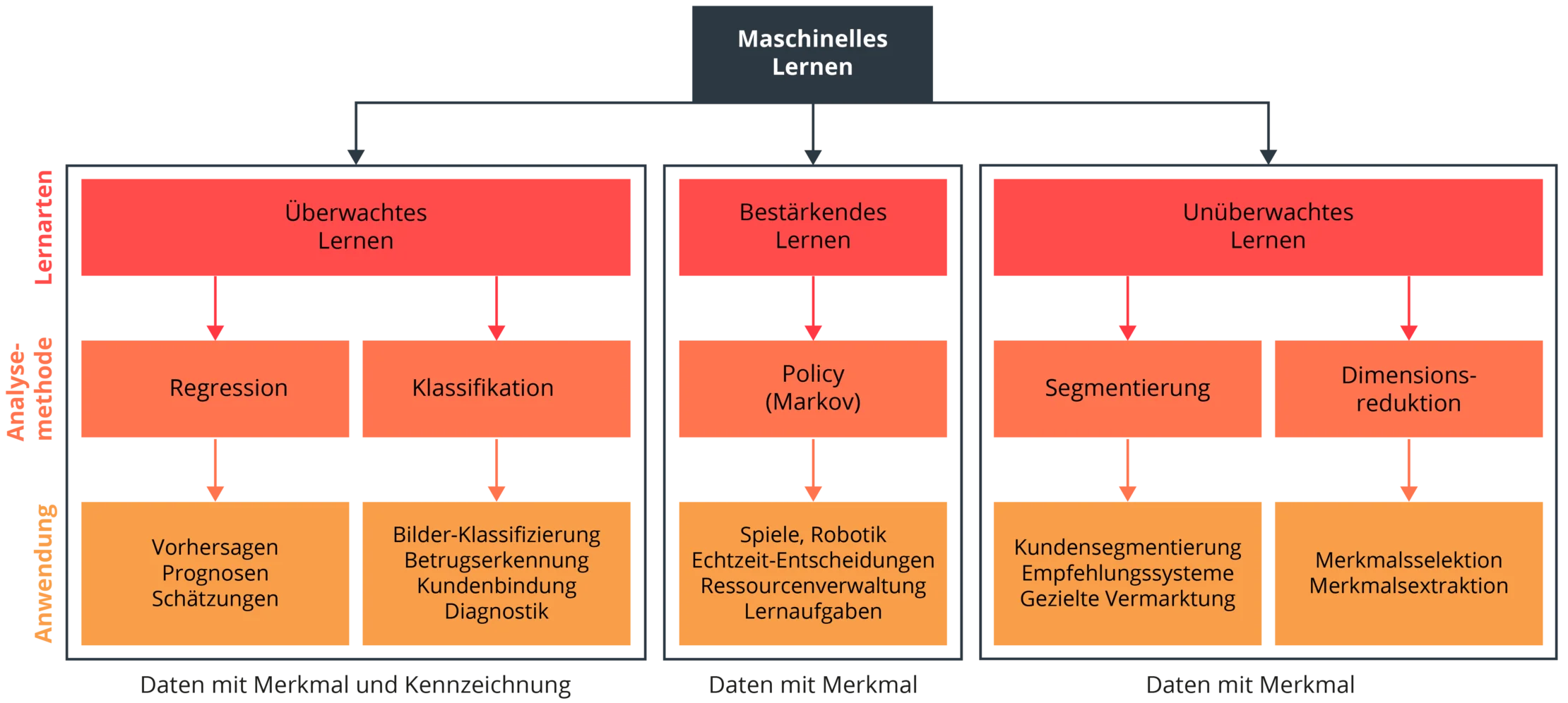

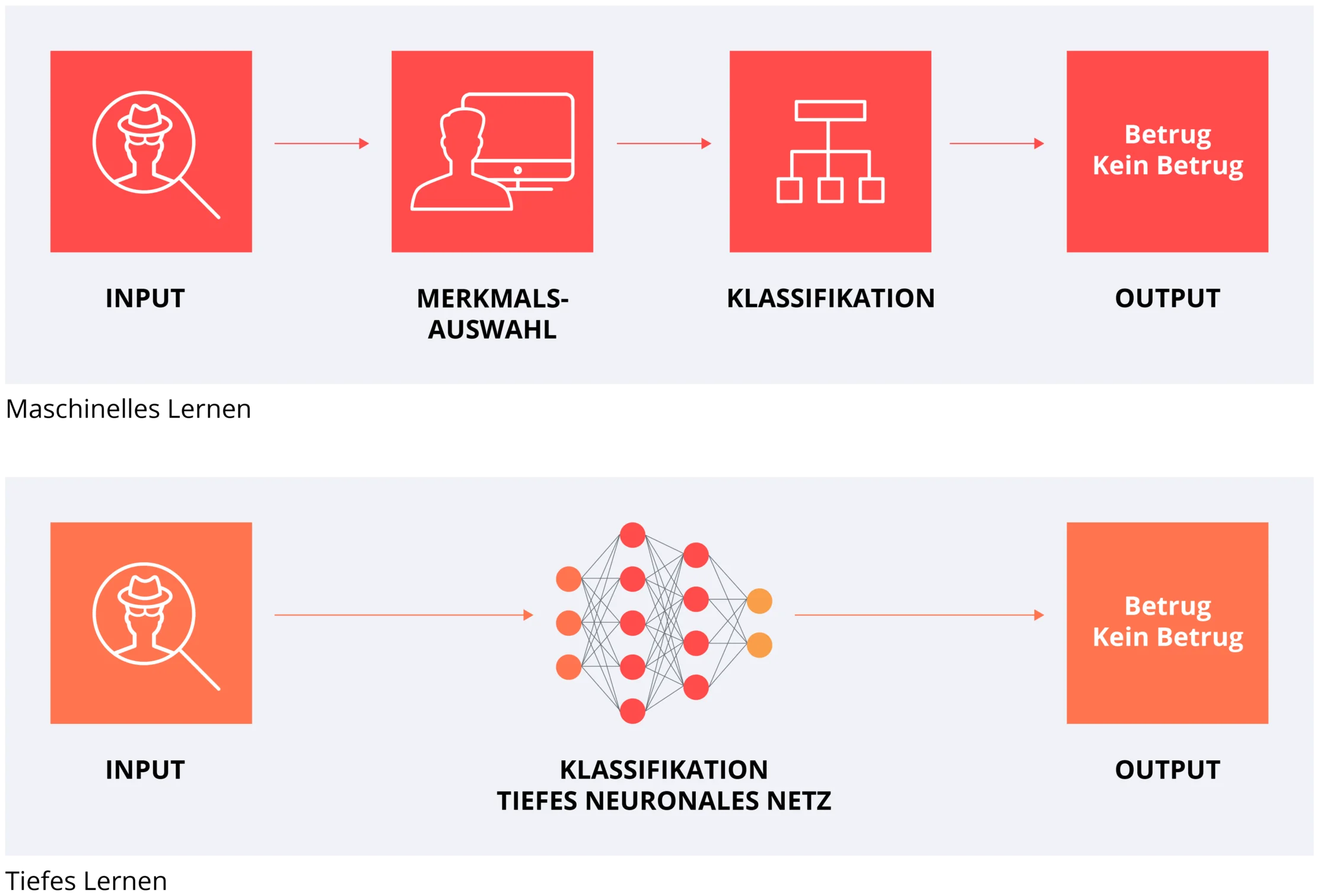

Maschinelles Lernen (Machine Learning) beschreibt die Anwendung von lernenden Algorithmen mit dem Ziel, Vorhersagen zu treffen oder unbekannte Muster und Gesetzmäßigkeiten in Daten zu entdecken. Diese lernenden Algorithmen werden anders als klassische Algorithmen nicht programmiert, sondern mittels Daten trainiert und stetig verbessert. Dadurch können Machine-Learning-Algorithmen flexibel in einer Vielzahl von Anwendungsgebieten eingesetzt werden. Je nach Use Case lassen sich unterschiedliche Machine-Learning-Modelle aufbauen und nutzen. Das maschinelle Lernen unterteilt sich in drei Arten: das überwachte Lernen (Supervised Learning), das unüberwachte Lernen (Unsupervised Learning) und das bestärkende Lernen (Reinforcement Learning).

Überwachtes Lernen (Supervised Learning)

Beim überwachten Lernen (Supervised Learning), besteht die Datenmenge aus einer Sammlung zuvor gekennzeichneter Daten. Die Daten bestehen aus Merkmalen (Features) und Kennzeichnungen (Labels). Das Ziel eines überwachten Lernalgorithmus besteht darin, anhand der Daten ein Modell zu entwickeln, das ein Merkmal oder eine Reihe von Merkmalen entgegennimmt und für neue Datensätze die Kennzeichnungen (Labels) vorhersagen kann. Das überwachte Lernen findet Anwendung in der Vorhersage und Prognose (Regression), der Betrugserkennung (Klassifikation), der Risikobewertung von Investitionen und der Berechnung der Ausfallwahrscheinlichkeit von Maschinen (Predictive Maintenance).

Unüberwachtes Lernen (Unsupervised Learning)

Beim unüberwachten Lernen (Unsupervised Learning) verwendet der Algorithmus eine Datenmenge, die ausschließlich aus Merkmalen (Features) besteht. Im Gegensatz zum überwachten Lernen weisen die Daten keine Kennzeichnung (Labels) und somit keine Zielvariable auf. Das Ziel des unüberwachten Lernens besteht darin, versteckte Muster und Gemeinsamkeiten in den Daten zu erkennen. Diese Muster und Gemeinsamkeiten können genutzt werden, um Daten zu gruppieren (Segmentierung) und die Komplexität eines Datensets zu reduzieren (Dimensionsreduktion). Durch die Anwendung dieser Methoden können Daten besser visualisiert und einfacher von Anwendern interpretiert werden. Zudem können die Ergebnisse der Algorithmen als Features für weitere Data Science Analysen genutzt werden. Klassische Anwendungsfälle für das unüberwachte Lernen sind die Kundensegmentierung, Empfehlungssysteme und die gezielte Vermarktung.

Bestärkendes Lernen (Reinforcement Learning)

Beim bestärkenden Lernen (Reinforcement Learning) hält sich die Maschine (Agent) in einer virtuellen oder realen Umgebung auf. Der Agent kann in dieser Umgebung Aktionen ausführen und wird durch ein Belohnungssystem und durch eine Kostenfunktion bewertet. Dabei erlernt der Agent eine Taktik (Policy), die seinen Nutzen maximiert. Die Maschine nutzt also Feedback aus der Interaktion mit ihrer Umwelt, um zukünftige Aktionen zu optimieren und Fehler zu vermeiden. Im Gegensatz zum überwachten und unüberwachten Lernen benötigt der Algorithmus keine Beispieldaten, sondern lediglich eine Umgebung und eine Bewertungsfunktion, anhand der er seine Aktionen optimiert. Das bestärkende Lernen findet in denjenigen Bereichen Anwendung, in denen die Entscheidungsfindung sequenziell erfolgt. Klassische Anwendungsfälle sind etwa Computerspiele, die Robotik, die Ressourcenverwaltung oder die Logistik.

Deep Learning

Deep Learning bezeichnet eine Teilmenge des maschinellen Lernens, bei der künstliche neuronale Netzwerke (Neural Networks) zum Einsatz kommen. Von tiefen neuronalen Netzwerken (Deep Learning) wird gesprochen, wenn das neuronale Netz mehr als eine Zwischenschicht hat. Neuronale Netze eignen sich besonders für komplexe Anwendungsfälle und / oder den Bereich der unstrukturierten Daten (Big Data). In einer Vielzahl von KI-Anwendungen (so beispielsweise bei der Sprachassistenz, der Gesichtserkennung oder dem autonomen Fahren) kommt Deep Learning bereits zum Einsatz und führt dabei immer wieder zu revolutionären und disruptiven Veränderungen.

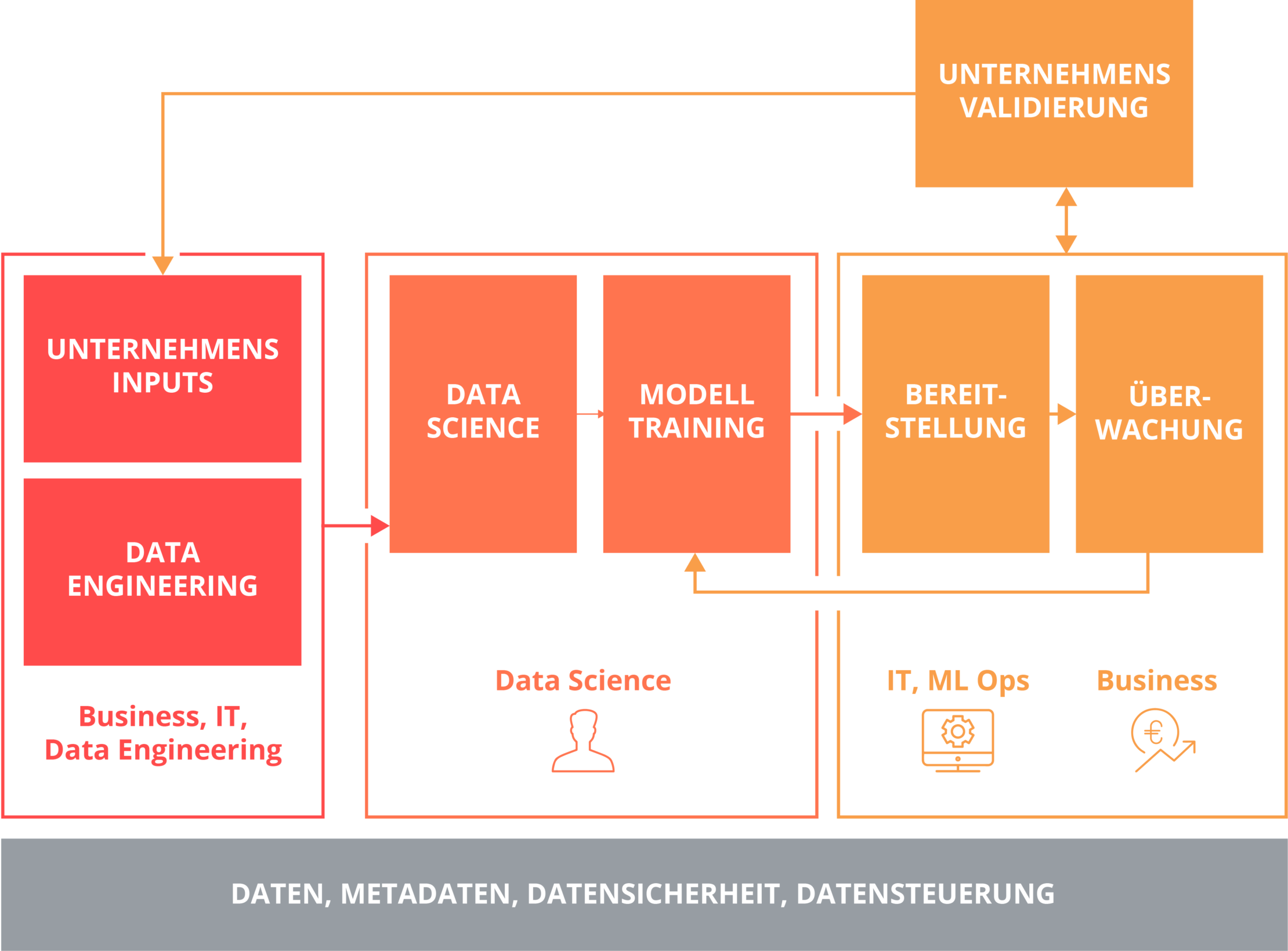

Maschinelles Lernen in Produktivumgebungen von Unternehmen

Bei der Einführung eines Data Science Anwendungsfalls in eine produktive Umgebung bestehen einige Herausforderungen. Die Implementation der Machine-Learning-Modelle (ML Code) stellt nur einen Bruchteil des Arbeitsaufwandes dar, den ein erfolgreiches Data Science Projekt ausmacht. Während Machine-Learning-Modelle oft auf Open-Source-Tools und -Werkzeugen basieren, arbeitet die klassische IT-Architektur häufig und aus gutem Grund mit proprietärer Software. Dieser Umstand macht eine enge Verzahnung von ML Code und IT Operations (MLOps) notwendig. Zu beachtende Faktoren sind dabei nicht nur die Bereitstellung der Machine-Learning-Modelle, sondern auch eine kontinuierliche Qualitätsprüfung. MLOps stellt eine effektive Nutzung der Analyseergebnisse sicher und sorgt so für eine gleichbleibende Qualität der Ergebnisse.

Die künstliche Intelligenz (KI) oder Artificial Intelligence (AI) hält Einzug in unser tägliches Leben. Morgens weckt uns unser Sprachassistenten. Auf dem Weg zur Arbeit wird uns aufgrund der aktuellen Verkehrslage eine vom regulären Arbeitsweg abweichende Umleitung vorgeschlagen. Über den Tag verteilt unterstützt uns das Smartphone dabei, Nachrichten und Texte zu verfassen. Am Abend verlassen wir uns auf die Empfehlungen eines virtuellen Agenten für passende Filme und Serien. KI begleitet uns, ohne dass wir es bemerken.

Im Bereich der KI geht es um die Entwicklung von lernenden Algorithmen, die das menschliche Verhalten nachahmen. Dabei wird grundsätzlich zwischen starker KI (Strong AI / General AI) und schwacher KI (Weak AI / Narrow AI) unterschieden. Starke KI meint die Entwicklung eines Systems, welches die gleichen intellektuellen Fähigkeiten wie ein Mensch besitzt und damit in der Lage ist, jegliche Arten von allgemeinen Problemen zu lösen. Eine schwache KI beschreibt ein System, das mithilfe von Daten speziell für einen konkreten Anwendungsfall entwickelt und trainiert worden ist. Während die starke KI noch Zukunftsmusik bleibt, wird die schwache KI bereits heute in vielen Unternehmensbereichen angewendet. Zu den gängigsten Anwendungen zählen:

Beim Einsatz von künstlicher Intelligenz ist es wichtig, langfristig zu denken. Künstliche Intelligenz kann nicht nur kurzfristig Kosteneinsparungen und Gewinne erzielen, sondern auch langfristig betrachtet völlig neue Geschäftsmodelle ermöglichen. Um diese langfristigen und nachhaltigen Mehrwerte bestmöglich zu realisieren, sollten KI-Projekte in eine unternehmensweite Strategie eingebettet werden. valantic unterstützt Unternehmen bei der strategischen Planung von KI-Projekten über die Konzeption von KI-Anwendungen bis hin zur Implementierung von KI-Systemen im produktiven Betrieb. Informieren Sie sich auf unserer Leistungsseite, wie Sie künstliche Intelligenz gewinnbringend in Ihrem Unternehmen einsetzen können.

Eine geeignete Data Science Plattform sollte nicht nur den Aufbau und die Nutzung von Machine-Learning-Modellen, sondern auch die Aufbereitung und Visualisierung der Daten ermöglichen. Mittlerweile häufen sich die Anbieter, die genau diese Funktionen bieten. Besonders Cloud-basierte Produkte (Software as a Service) erfahren ein rasantes Wachstum. Neben den klassischen Softwareanbietern wie IBM, Microsoft, SAP und SAS versuchen auch jüngere Unternehmen wie Databricks, Dataiku oder DataRobot ihre innovativen Produkte am Markt zu etablieren. Während die jüngeren Unternehmen auf schlanke und benutzerfreundliche Data Science Plattformen setzen, bieten die großen Softwareanbieter stark individualisierbare Lösungen an, die oft für komplexe Unternehmensanforderungen nötig sind.

Viele dieser Cloud-basierten Produkte zeichnen sich durch eine schnelle und einfache Implementierung aus und besitzen meist eine Plattform, über die sich Data Scientists, Analysten und Fachanwender austauschen können. Durch vordefinierte Prozesse ist es selbst Fachanwendern möglich, komplexe Algorithmen auszuführen sowie die Ergebnisse zu interpretieren und zu teilen. Mit Hilfe von KI-Funktionalitäten können viele Tools per Mausklick unternehmensspezifische Analysen erstellen. Ferner stärken die Tools durch Ihre Visualisierungsfähigkeiten die Interpretation der zugrunde liegenden Daten. Das wiederum reduziert die Initialkosten und erleichtert den Einstieg in komplexere Data Science Projekte.

Neben den etablierten Softwareanbietern und den jüngeren Unternehmen stellen Programmiersprachen wie Python und R ein valides Mittel dar, um Daten zu bearbeiten, zu visualisieren und eigene Machine-Learning-Modelle zu erstellen und zu nutzen. Dafür gibt es vordefinierte Open-Source-Bibliotheken. Aufgrund ihrer Flexibilität sind die Programmiersprachen Python und R meist die erste Wahl für Data Scientists. Um die Brücke zwischen Analysten, Fachanwendern und Data Scientists zu schlagen, sind diese beiden Programmiersprachen inzwischen in Data Science Plattformen und -Tools integriert. Das ermöglicht eine bessere Zusammenarbeit und steigert so die Produktivität des gesamten Teams.

Durch unsere Partnerschaften mit etablierten Softwareanbietern und der Nutzung von Open-Source-Bibliotheken und Tools ist es uns möglich, für jeden Kunden eine passgenaue Lösung zu entwickeln. Profitieren Sie von unserem Know-how und setzen Sie die richtigen Data Science Tools und -Plattformen gemeinsam mit valantic gewinnbringend in Ihrem Unternehmen ein.

Daniel Völker

Lead Consultant Data Science

valantic